La inteligencia artificial (IA) ya está en las redacciones. Asiste en la edición, propone titulares y hasta genera borradores completos. Pero mientras las herramientas se integran con rapidez, los criterios éticos avanzan con más lentitud.

¿Qué se puede automatizar y qué no? ¿Cuándo se debe atribuir una autoría? ¿Quién revisa los sesgos que pueda replicar la IA? Estas preguntas no se resuelven solas, y dejarlas sin respuesta puede poner en riesgo la credibilidad del medio.

En esta entrega de Hablemos Editorial, exploramos por qué es necesario crear un Comité de IA en tu redacción y cuáles son los primeros pasos para establecer reglas claras, responsables y adaptables.

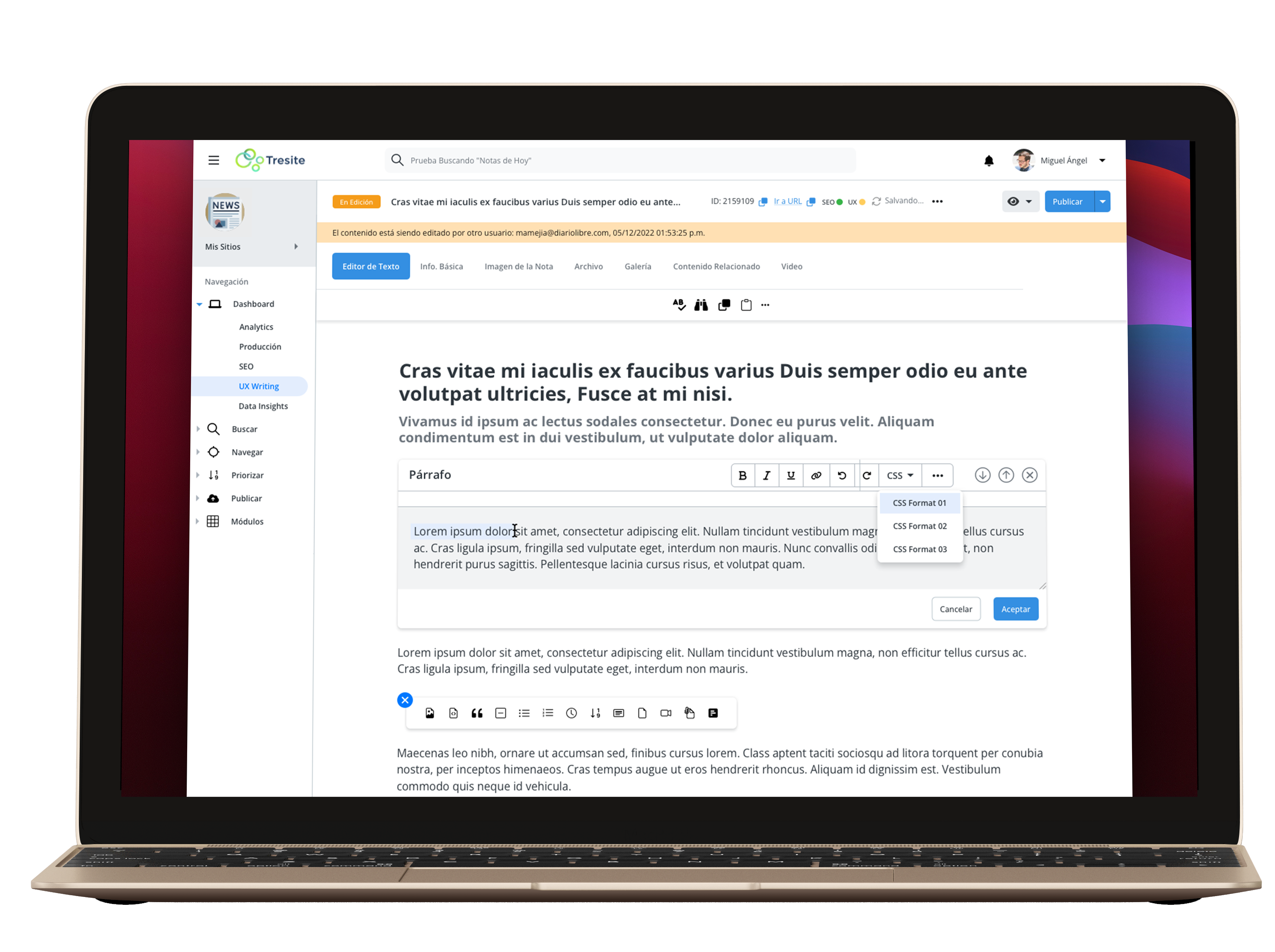

Imagen: Dall-E

La IA no es solo una herramienta técnica. Toca decisiones editoriales, afecta la relación con las audiencias y plantea dilemas sobre transparencia, veracidad y propiedad intelectual. Por eso, su implementación no debe quedar únicamente en manos del equipo de tecnología o producto. Es indispensable un espacio interdisciplinario que revise el uso de estas herramientas desde una perspectiva editorial, legal y ética.

Algunos medios internacionales ya han publicado sus lineamientos: Wired ha restringido el uso de IA en la generación de texto, The Guardian ha hecho pública su política de transparencia, y The New York Times incluso actualizó sus términos de uso para proteger sus contenidos de ser usados en entrenamiento de modelos. Pero estos medios no son los únicos, cada vez es más común encontrar medios que han determinado que cada decisión editorial requiere evaluar beneficios, riesgos y consecuencias a mediano plazo.

Primeros pasos para estructurarlo

¿Solo supervisará herramientas generativas? ¿O también sistemas de recomendación, moderación automática y asistentes de búsqueda interna?

Invita a editores, periodistas, desarrolladores, diseñadores UX, representantes legales y, si es posible, alguien externo con experiencia en ética digital o derechos humanos.

No se trata de prohibir o permitir todo, sino de establecer criterios que ayuden a tomar decisiones caso por caso. La guía debe abordar temas como atribución, correcciones, protección de fuentes y sesgos algorítmicos.

¿Cómo se evaluarán nuevas herramientas? ¿Qué validaciones técnicas y editoriales se exigirán antes de integrarlas? ¿Cómo se documentará su uso?

Las capacidades de la IA cambian rápido. También deben hacerlo los protocolos. Define una periodicidad clara para revisar los lineamientos y abre canales de retroalimentación interna.

Y claro está, documenta los casos que se vayan dando para así tener respuestas prontas basadas situaciones reales con los que se van enfrentando.

Más allá del control, se trata de confianza.

Una redacción que tiene claridad sobre cómo y por qué usa IA puede explicárselo mejor a su audiencia. Y en un contexto de desinformación y automatización creciente, eso se traduce en reputación, diferenciación y sostenibilidad. No basta con adoptar la tecnología: hay que gobernarla.

¿Tu medio ya está dando estos pasos? Escríbenos para conversar sobre cómo te podemos acompañar desde Tresite.

Alcanza más audiencia, mejora la calidad de tus contenidos, monetiza, reestructura tu redacción, optimiza recursos e incrementa el tráfico a tus publicaciones.

Tu transformación empieza aquí